Świat fotografii to nie jest świat inżynierów, tylko artystów. A więc jest to świat pełen wierzeń, myślenia magicznego, legend i mitów. Co ciekawe wiele z tych mitów brzmi całkiem racjonalnie i byłyby one całkiem prawdziwymi twierdzeniami, gdyby nie pominięto ważnych założeń. Jednym z takich mitów jest mantra pana fotografa doradzającego synowi sąsiadów jaki aparat kupić. Mówi "nieważny jest aparat. Najważniejszy jest obiektyw". To było prawdziwe wtedy, gdy gros dostępnych dla przeciętnego zjadacza chleba aparatów fotograficznych było "napędzane" małoobrazkowym filmem i przy założeniu, że tylko spośród nich amator wybierał. W czasach cyfrowych to już jest nie do końca prawda, ponieważ nawet jak się kupuje pierwszy aparat można wybierać w rozmiarach klatek. Andrzej Mroczek swojej książce "O fotografowaniu" już w czasach filmu pisał, że rozmiar negatywu (dziś napisałby, że matrycy) ma znacznie większy wpływ na jakość obrazu, niż jakość obiektywu. I wiecie co? ON miał rację. Rozmiar ma znaczenie. Nie tylko całości kadru zresztą. Dlatego zapraszam na dwa odcinki poświęcone rozmiarom. W pierwszym odcinku...

Święte szumy

Tak naprawdę jednego parametru, który można by nazwać "jakością obrazu" nie ma. Na to, czy obraz będzie wydawał nam się dobrej, czy złej jakości składa się bardzo wiele czynników, m.in. ostrość, kontrast, odwzorowanie i nasycenie barw, jasność... W czasach cyfrowych właściwie liczy się tylko jeden: szumy na wysokich czułościach. Choć, jako człowiek przestarzały robiący większość zdjęć na filmach (które akurat pod względem szumienia na wysokich czułościach są dużo gorsze od cyfraków) nie do końca podzielam tą manię, to skoro jest to dla Was ważne to proszę.

O wpływie rozmiarów pikseli i matrycy na stosunek sygnału do szumu (co się oznacza SNR od "Signal to Noise Ratio") przy określonym naświetleniu i czułości można opowiedzieć całkiem precyzyjnie, jednak pod warunkiem zastosowania pewnych założeń. Takich jak na przykład "przy tej samej technologii". I to jest ważne, bo jak się porównuje dwa prawdziwe aparaty, to się okazuje, że różnice w osiągach tych aparatów są inne niżby to wynikało z samych rozmiarów matryc, czy pikseli, a więc technologia jednak ma znaczenie. Czyli kolejny przykład mitu typu "byłoby prawdziwe, gdybyśmy pamiętali o założeniach".

Jeden piksel

Tu jest ten kawałek, w którym obiegowe opinie są zgodne z prawdą. Jeżeli przy określonym poziomie technologii zmniejszymy piksel to stosunek sygnału do szumu się zmniejszy (pogorszy) i to nawet można mniej więcej oszacować jak bardzo. Załóżmy, że jeden piksel (tak samo dobry z technologicznego punktu widzenia) będzie miał powierzchnię 2 razy mniejszą, niż drugi (czyli jego bok będzie ok. 1,41 razy krótszy). To oznacza, że po naświetleniu go światłem o takim samym natężęniu przez taki sam czas zarejestrowanych fotonów będzie dwukrotnie mniej. A więc sygnał wysłany do dalszej obróbki będzie dwukrotnie słabszy. A zatem stosunek sygnału do szumu (czyli SNR) się pogorszy.

Aby mniejszy piksel dał taką samą wartość SNR musimy go dwa razy dłużej naświetlić, czyli obniżyć czułość o jedną działkę. I oto odpowiedź: dwa razy mniejszy piksel będzie tak samo bardzo szumiał co dwa razy większy, jeżeli obniżymy czułość dwukrotnie, czyli o jedną działkę.

Tylko co z tego wynika? Dwa modelowe przypadki:

Tyle samo pikseli, ale w dwóch różnych rozmiarach

Tu nadal nie wykraczamy poza to, co jest zgodne z intuicją przeciętnego fotografa. Jeżeli dwie matryce mają taką samą liczbę pikseli, to jeżeli jedna ma powierzchnię powiedzmy dwukrotnie większą, to każdy jej piksel będzie dwa razy większy od pikseli na tej mniejszej matrycy. Czyli będzie miał przy tej samej czułości lepszy stosunek sygnału do szumu, ewentualnie tą samą wartość SNR będzie osiągał dla czułości o działkę wyższej.

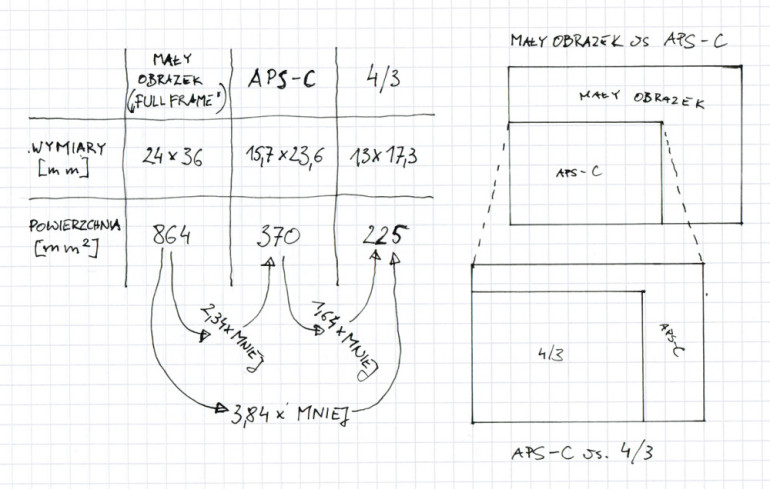

W tym miejscu warto zdać sobie sprawę jak się mają różne standardowe rozmiary sensorów do siebie, bo tak naprawdę to nam implikuje jakie efekty możemy uzyskać.

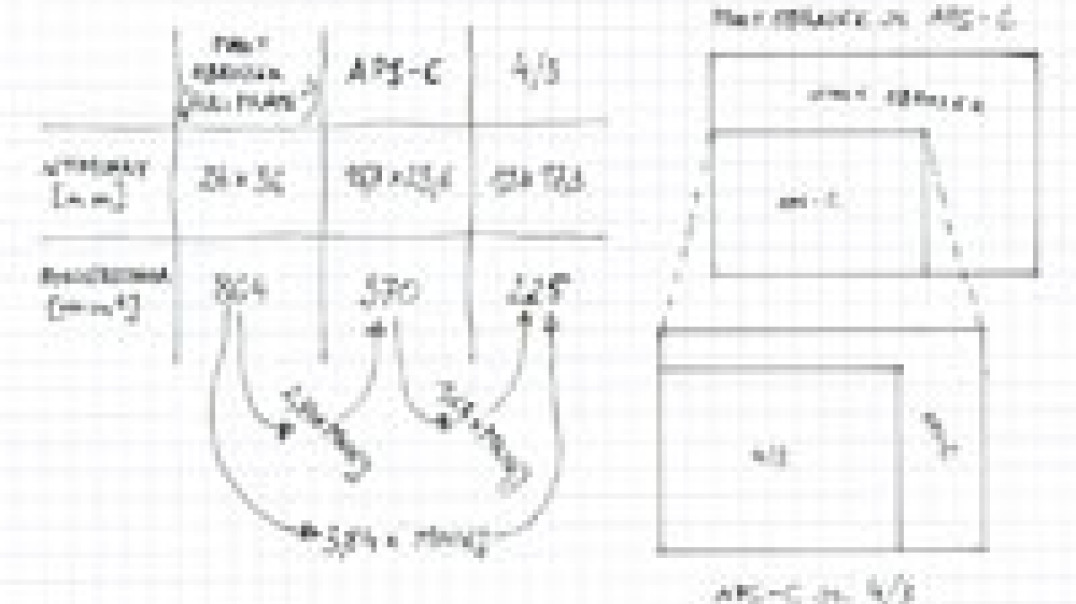

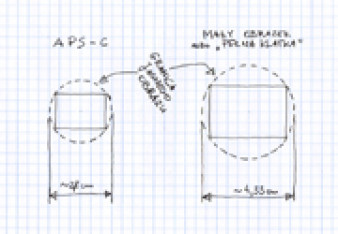

Trzy chyba najbardziej dyskutowane rozmiary, czyli mały obrazek (zwany inaczej "pełną klatką" lub "ful frejmem"), APS-C i 4/3 mają rozmiary mniej więcej takie (w przypadku APS-C wziąłem rozmiar najpopularniejszy, i zarazem największy):

Matryca 4/3 jest 3,84 razy mniejsza od małoobrazkowej. Czyli jeżeli zrobimy matryce tak samo dobrze, to, aby na zdjęciach dostać tak samo mało szumu aparat 4/3 trzeba ustawić na czułość o dwie pełne działki mniejszą, niż pełnoklatkowy (zaokrągliłem do 1 DINa, czyli do 1/3 działki). Różnica wynikająca z samych rozmiarów jest taka i NIE jest większa (choć dwie działki to wcale nie jest mało). Reszta różnic to różnice w technologii i w... podejściu projektantów do tego, co jest ważniejsze w obrazie wyjściowym.

Gdzie w tym porównaniu leży matryca APS-C? Otóż matryca APS-C (ta największa) jest ok. 2,3 raza mniejsza od małoobrazkowej i tylko 1,64 raza większa od matrycy 4/3. A zatem leży właściwie w 1/3 drogi pomiędzy formatem 4/3 a "pełną klatką". Warto o tym pamiętać, bo jakby czytać to, co piszą ludzie na forach, to można odnieść wrażenie, że format 4/3 jest rzekomo niewiele większy od tych stosowanych w kompaktach. A tak naprawdę, to jeżeli ustawimy czułość pełnoklatkowca na, załóżmy ISO 800, to aby uzyskać tak samo dobry obraz aparat 4/3 trzeba ustawić na ISO 200, a APS-C - na ISO 320.

Dwie matryce tych samych rozmiarów, ale o różnych rozdzielczościach

W ciągu już przynajmniej kilkunastu lat rozwoju aparatów cyfrowych jedną z niewielu niezmiennych rzeczy było narzekanie na "wojnę na piksele". Co ciekawe przekonanie o tym ile pikseli być powinno na matrycy jednak ewoluowało razem z matrycami. Pamiętam, że jak wchodziły matryce z 8 milionami pikseli, to 8 to było za dużo, bo wystarczy 5 milionów. Gdy potem wchodziły matryce 10-milionowe, to 10 było za dużo, ale 8 było już dobrze. Wtedy 5 milionów to już jednak wydawało się za mało.

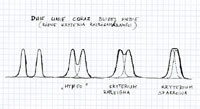

Wydaje się to całkiem logiczne. Skoro mniejszy piksel ma gorszy stosunek sygnału do szumu, to lepiej jak matryca ma mniej dużych pikseli, niż więcej małych, prawda? NIE! Bo w sumie skoro mniej znaczy lepiej, to czemu nie... jeden piksel?

Przekonanie to bierze się błędu, jaki jest powielany w niemal każdym współczesnym teście aparatu. Jak mowa o szumach, to wyświetla się mały fragment całego zdjęcia w rozmiarze 1:1 (czyli piksel do piksela) i na tej podstawie pisze, że ten a nie tamten szumi bardziej. Tylko, że jeżeli wyświetlimy sobie powiedzmy kawałek 300x400 pikseli ze zdjęcia o rozdzielczości 12 milionów pikseli to jest to 1% całego kadru. Ale to samo 300x400 pikseli z 5 milionów, to jest to już prawie 2,5% klatki, czyli ponad 2 razy więcej. To jest tak samo, jak porównanie ostrości dwóch obiektywów: zdjęcie zrobione pierwszym powiększamy do rozmiarów 30x40cm, a zrobione drugim - do rozmiarów 25x19cm, po czym z obu zdjęć wycinamy kawałek 3x4cm i porównujemy te kawałki. Uczciwe?

Tak naprawdę jeżeli zmniejszamy piksele na matrycy określonego rozmiaru to mamy dwa przeciwstawne zjawiska. Po pierwsze wartość SNR dla każdego pojedynczego piksela się pogarsza, jak to napisałem wyżej. Ale po drugie ten sam fragment zdjęcia zaczyna się składać z większej liczby pikseli. Jeżeli patrzymy na całe zdjęcie z jakiejś odległości oczy uśredniają pojedyncze piksele i fluktuacje widzimy słabiej. I niestety (albo raczej na szczęście) wbrew obiegowej opinii fakt, że obraz składa się z większej liczby pikseli bardziej poprawia stosunek sygnału do szumu, niż go pogarsza fakt, że każdy z pikseli bardziej szumi.

Na przykład

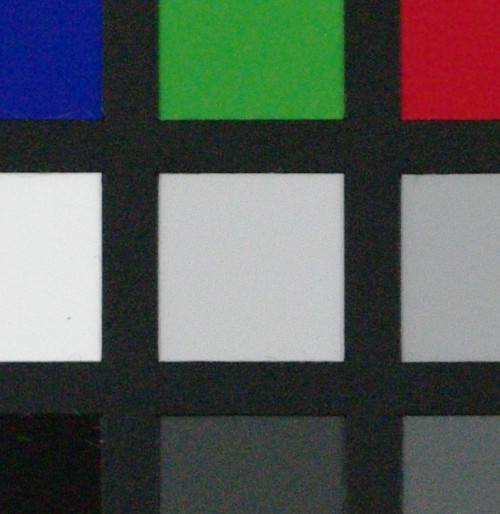

Pożyczyłem sobie z testów fotopolis zdjęcia z dwóch aparatów tej samej firmy na P, oba robione przy czułości ISO 1600. Jedno pochodziło z dość powszechnie (choć nie do końca sprawiedliwie) krytykowanego za szumy aparatu o rozdzielczości 14,6 mln pikseli:

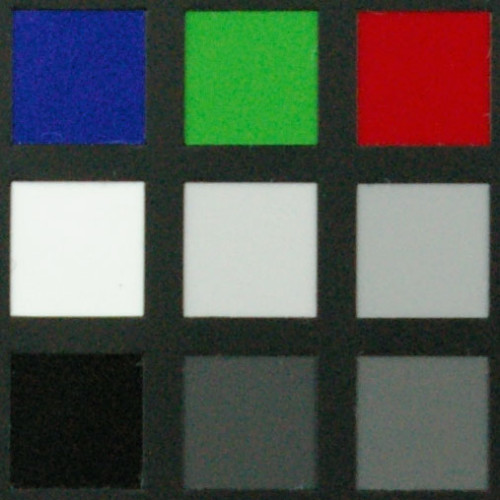

Drugie, z troszkę starszego aparatu o rozdzielczości 6 mln pikseli:

I co? Wyraźnie pierwszy ma większe szumy.

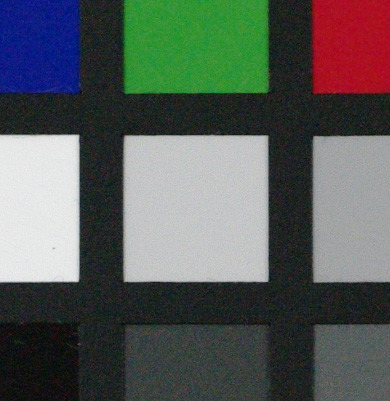

Tyle tylko, że jeżeli przeskalujemy zdjęcie tak, jakby całość miała 6 milionów pikseli (tak, aby je oglądać w tym samym powiększeniu) to będzie wyglądało tak:

I się okazuje, że zdjęcie przeskalowane ma szumy w zależności od miejsca takie same lub wyraźnie mniejsze, za to ostrość kompletnie z innej półki.

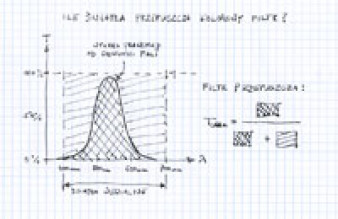

Tu się od czasu filmów nic nie zmieniło

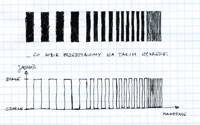

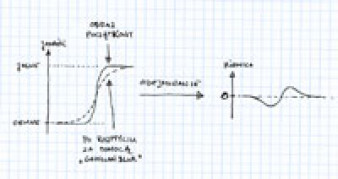

W dawnych czasach ludzie wiedzieli, że mniejsze ziarno to mniej zaszumione zdjęcie, a większe ziarno – bardziej. To, co dziś nazywamy szumami wtedy nazywano ziarnistością negatywu. Testowano to zasłaniając negatyw blaszką z dziurką i sprawdzając, jak bardzo będzie się zmieniać gęstość optyczna negatywu w miarę przesuwania tej blaszki nad negatywem. Dziurka była zawsze taka sama - 48 mikrometrów średnicy. Im mniejsze było ziarno, tym więcej ziarenek było widać przez dziurkę i fluktuacje gęstości optycznej negatywu mierzone wraz z przesuwaniem dziury nad negatywem mniejsze. I to się zgadzało - obraz z całego negatywu był bardziej gładki i mniej zaszumiony. Nigdy, przenigdy nie widziałem testu, w którym ktoś stwierdziłby, że skoro ziarno negatywu ma mniejsze rozmiary, to należy do pomiarze wziąć mniejszą dziurę (tak, aby jej średnica była zawsze na przykład 10x większa od średniej wielkości kryształu halogenku srebra w emulsji). Gwarantuję, że z takiego pomiaru też by wyszło, że negatyw z mniejszym ziarnem by bardziej szumiał. Bo jeżeli w negatywie zmniejszamy ziarno, to "stosunek sygnału do szumu" pojedynczego kryształka halogenku srebra też się pogarsza.

Skoro już jesteśmy przy szumach, to może jeszcze taka mała dygresja. Dla odmiany napiszę coś praktycznego ;)

Jak naświetlać zdjęcia cyfrówkami

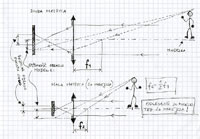

Jak ludzie robili zdjęcia na negatywach, to była zasada "naświetlaj na cienie, wywołuj na światła". W cyfrówkach obowiązuje zasada odwrotna: Jak chcesz mieć mało szumów, to, robiąc zdjęcia w RAWach należy naświetlić zdjęcie zawsze tak, aby było możliwie najjaśniejsze, choć aby jeszcze nie tracić szczegółów w światłach. Dlaczego?

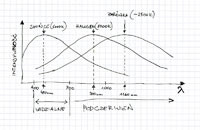

Człowiek postrzega jasność (podobnie jak wysokość dźwięku, głośność, a nawet tak abstrakcyjne rzeczy jak ceny) w skali logarytmicznej. Mówiąc inaczej tak, jak przysłona. Różnica jasności pomiędzy żarówkami 130W, a 100W wydaje nam się dużo mniejsza, niż pomiędzy żarówką 60W, a 30W. To dlatego, że nie widzimy dobrze o ile jedno światło jest jaśniejsze od drugiego, tylko ile razy jest jaśniejsze. Więc jeżeli chcemy, aby żarówka była jaśniejsza od 100W o taką samą działkę, jak różnica pomiędzy 60W, a 30W, to musimy wziąć 200W. Aby zrobiło się znowu o tyle samo jaśniej trzeba wziąć 400W, bo 300W nie wystarczy itd.

A więc jak będziemy otwierać przysłonę o kolejne działki, to obraz będzie nam się wydawał jaśniejszy o kolejne takie same działki, choć w rzeczywistości z każdą działką światła będzie dwa razy więcej.

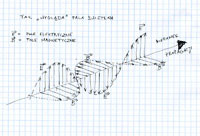

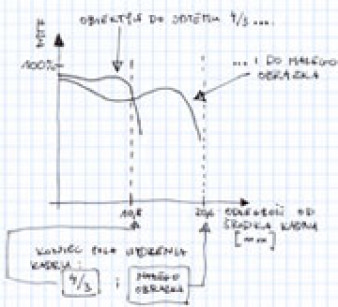

Otóż sensor aparatu widzi liniowo. Fotokondensator będący detektorem w pikselu w wyniku naświetlania gromadzi ładunek, który jest potem zamieniany na napięcie, które jest z kolei sygnałem analogowym, który (po przeróbkach jeszcze) idzie do konwertera analog-cyfra. Ten konwerter TEŻ działa liniowo, to znaczy, że jeżeli piksel zostanie naświetlony dwa razy (czyli o jedną działkę przysłony) mocniej, to liczba (czyli wyjściowy sygnał) jaka zostanie zapisana w RAWie będzie też dwa razy większa.

I zobaczcie co z tego wynika. Załóżmy, że konwerter analog-cyfra jest 12-bitowy, czyli, że w RAWie mamy do dyspozycji 4096 poziomów jasności. Jeżeli mamy scenę o dużej rozpiętości, to na najjaśniejszą 1 działkę przysłony przypada połowa, czyli 2048 poziomów. Następna przysłona to już połowa z połowy dostępnych poziomów, czyli poziomy od 1025 do 2048 (w sumie 1024 poziomy). Następna przysłona (tu mieści się "średnia szarość" do jakiej światłomierze nam sprowadzają każdą scenę) to 512 poziomów o numerach od 513 do 1024. I tak dalej i tak dalej.

Jeżeli teraz naświetlimy na światła - czyli nawet prześwietlimy sobie tą średnią szarość, aby światła były możliwie blisko białego (ale jeszcze się nie nasycały) to wykorzystujemy wszystkie 4096 rejestrowanych poziomów jasności. Ale jeżeli przymkniemy przysłonę o jedną działkę, to dostępna liczba poziomów jasności skurczy nam się o połowę. Takie zdjęcie nie będzie o jedną działkę gorsze, tylko dwa razy gorsze

_1663272818.jpg)

_1826294941.jpg)