Funkcje pozwalające imitować płytką głębię ostrości i rozmycie tła charakterystyczne dla jasnych profesjonalnych obiektywów wszyscy dobrze znamy z naszych smartfonów. I choć z roku na rok smartfonowe aparaty stają się pod tym względem coraz doskonalsze prawdziwym game-changerem w branży byłoby zaadaptowanie tej funkcji na potrzeby tradycyjnych, systemowych aparatów.

Bo fotografowanie smartfonem, a praca i realizacja zleceń to w doskonałej liczbie przypadków dwie zupełnie odrębne rzeczy. A to właśnie fotografom aspirującym do miana zawodowców tego typu funkcja mogłaby pomóc najbardziej, gdyż - jeśli byłaby wystarczająco dopracowana - w wielu przypadkach zniwelowałaby konieczność inwestycji w drogie, jasne szkła. (Oczywiście superjasne obiektywy to też możliwości pracy na niższym ISO w słabym świetle, ale i tak większość osób kupuje je ze względu na charakter dostarczanego obrazka).

Funkcja Depth Blur zawitała do Photoshopa - czy jest skuteczna?

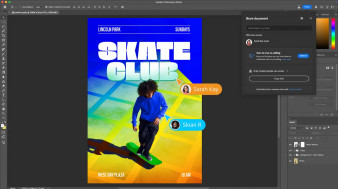

I oto właśnie, wraz z ostatnią, majową aktualizacją pakietu Creative Cloud, Photoshop otrzymał nowy filtr Depth Blur, który w założeniu ma właśnie na to pozwalać, w dodatku wymagając od nas w tym celu tylko kontroli pojedynczego slidera. Czy więc już możemy pozbyć się zestawu jasnych stałek, na który przez lata ciężko pracowaliśmy? Nie tak prędko.

Jak na razie działająca w ramach Neural Filters funkcja Depth Blur jest udostępniana w fazie beta i jak możemy zobaczyć w powyższej wideorecenzji - radzi sobie raczej marnie. Co więcej, nadal lepsze rezultaty jesteśmy w stanie uzyskać za pomocą ręcznej edycji masek i filtrów. Być może jednak szybko się to zmieni.

Dzięki rozwojowi algorytmów software'owe rozmycie tła z biegiem czasu będzie stawać się coraz doskonalsze. Czy producenci są na to gotowi?

Jak wszystkie funkcje z pakietu Neural Filters, tak i Depth Blur bazuje na sieciach neuronowych, a edycja zdjęcia odbywa się na zewnętrznym serwerze Adobe, co pozwala firmie dalej szkolić algorytm odpowiedzialny za symulację rozmycia. Z dużym prawdopodobieństwem jej działanie w niedługim czasie zostanie znacznie usprawnione (aktualnie filtr oznaczony jest jako wersja beta), oddając w ręce użytkowników gotowy i użyteczny produkt (w końcu tak samo przez lata dojrzewały funkcje pokroju Content Aware Fill czy automatycznego zaznaczania obiektu).

Dziś chyba nikt nie ma już wątpliwości, że przyszłość postprodukcji będzie opierać się o funkcje AI, wytrenowane za pomocą sieci neuronowych. Okazuje się jednak, że przyszłość ta zawitała u naszych drzwi szybciej niż myśleliśmy. [Czytaj więcej]

Jeśli tak się stanie, możemy spodziewać się małej rewolucji, na którą odpowiednio będą musieli zareagować producenci optyki. I nie dlatego, że jasne szkła z dnia na dzień przestaną się sprzedawać. Dotychczasowi profesjonaliści będą z nich korzystać jeszcze długie lata, natomiast coraz trudniej ich sens będzie wytłumaczyć pokoleniu fotografów, które dorasta w otoczeniu rozwiązań AI i dla którego wspomniane filtry są tylko kolejną (i łatwiejszą) formą dotarcia do celu.

Więcej informacji na temat działania filtrów z pakietu Neural Filters znajdziecie na stronie helpx.adobe.com.

_1105457014.jpg)